apsheronsk.bozo.ru/Neural/Hebb_code.html

Пример кода нейронной сети обучающейся без учителя

Краткое описание глобальных переменных:

HEBB, SIGNAL_HEBB, KOHONEN – типы обучения нейросети. Присваивается в переменной LEARNING_TYPE.

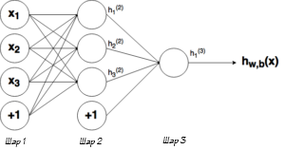

Layers – количество слоев нейронной сети, определяется автоматически из заданного массива GNeuro[]. В GNeuro первый элемент – это количество входов, последний – количество выходов нейросети. То, что между – соответственно количество нейронов скрытых слоев. Например:

GNeuro[4, 8, 12, 6] – задает нейросеть с 4 слоями, во входном слое 4 нейрона (которые только распределяют входной сигнал на следующий слой), 8 – количество нейронов в первом скрытом слое, 12 – количество нейронов во втором скрытом слое, 6 – количество нейронов в выходном слое.

GMatrix – матрицы весов сети, первое измерение – номер слоя -1, дальше i и j матрицы.

Input – входной вектор;

Output – выходной (предустановленный – не используется).

Краткое описание функций:

start() – собственно здесь пишется последовательность функций, которые надо выполнять.

SetParams() – установка параметров сети, инициализация матриц.

InitNet() – загоняем рандомом веса синаптических связей нейросети.

Calc() – расчет выхода нейросети по заданному номеру входного образца.

TestCalc() – тестовая, для проверки правильно ли перемножает сеть матрицы и вектора.

SetIO() – установка входов.

Hebb() – здесь в цикле рандомом выбираются примеры для обучения и сеть пытается обучиться.

Если имеются благодарности, то они принимаются на WMR R398365873120

Возможна доработка исходников под конкретную задачу (за отдельную плату).

С Уважением, к.т.н. Шумков Е.А. (КубГТУ)

[email protected]

// Реализация многослойного персептрона с обучением по правилу Хебба (MQL4, Metatrader)

так как код нельзя вставить, прикрепляю его ниже